Tutti sperano sempre di poter disporre di un dataframe completo, le cui feature vantino un’omogenea profondità dei dati, in modo da poter porre delle solide basi per iniziare a sviluppare un modello di Machine Learning. Purtroppo, nel mondo reale, ciò che accade è perfettamente l’opposto ed è consuetudine dover manipolare dataset contenenti valori mancanti.

Solitamente, la prima soluzione a portata di mano sembra essere la rimozione delle righe che riportano valori blank o NaN. Tuttavia, questa scelta spesso può essere controproducente, in quanto può comportare la perdita di un’informativa preziosa, soprattutto in casi in cui il dataset dispone già di una scarsa profondità storica. Perciò, data la frequenza di accadimento ed il peso di questa problematica sulle performance dei risultati, è sembrato opportuno portare all’attenzione dei nuovi spunti da prendere in considerazione in fase di Preprocessing. In particolare, una soluzione risultata vincente, in alternativa ad approcci classici quali la PCA (Principal Component Analysis) e la Feature Selection, è l’imputazione dei dati mancanti, ovvero, ricavare quest’ultimi dai dati noti.

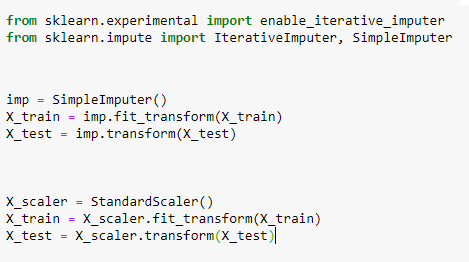

L’imputazione di tipo “univariata” prevede il completamento dei valori mancanti di una specifica feature utilizzando le dimensioni a disposizione della feature medesima. In Python, in questi casi si utilizza il pacchetto SimpleImputer della libreria sklearn.impute, il quale prevede di default l’imputazione delle feature facendo la media dei dati noti. In alternativa, è possibile impostare come metodo la mediana, il most_frequent (str) e constant (str).

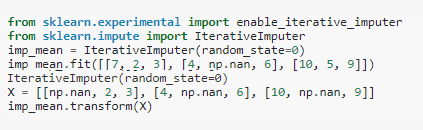

Infine, un ulteriore approccio utilizzato per il riempimento del dataset, di tipo “multivariato”, prevede le feature con valori mancanti come funzione delle altre feature mediante una schedulazione Round Robin. In Python, per questo approccio viene utilizzato l’IterativeImputer, sempre dalla libreria sklearn.impute.

L’approccio multivariato è sicuramente più sofisticato rispetto a quello univariato. Ad ogni modo entrambi gli approcci, sia SimpleImputer che IterativeImputer, possono essere utilizzati in una pipeline come un modo per costruire uno stimatore composito che supporti l’imputazione.

Autore: Francesca Giannella | Senior Data Scientist DMBI

Photo by Marisa Morton on Unsplash